Apple vient d’annoncer de nouvelles fonctions sur iOS 15. Ces nouvelles mesures visent à apporter une nouvelle protection pour les enfants sur l’iPhone, l’iPad et le Mac.

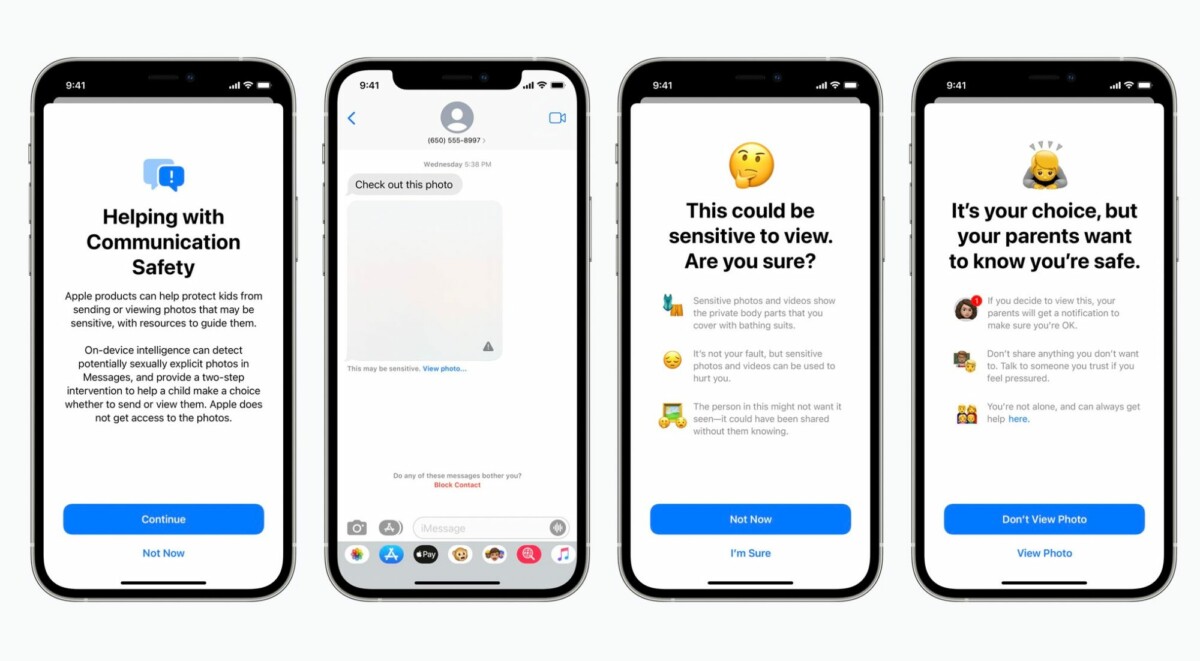

Messages pourra flouter les images sexuellement explicites

La première fonction concerne l’application Messages. Dans un compte iCloud familial, si un enfant de la famille reçoit ou tente d’envoyer des photos sexuellement explicites, l’image sera floue et un message d’avertissement sera affiché sur l’écran.

Dans un communiqué de presse, Apple explique que Messages utilise l’apprentissage automatique directement sur l’appareil pour analyser les pièces jointes et déterminer si une photo est sexuellement explicite. iMessage reste chiffré de bout en bout et Apple n’a accès à aucun des messages analysés.

Lutter contre la pédopornographie en scannant le contenu des iPhone

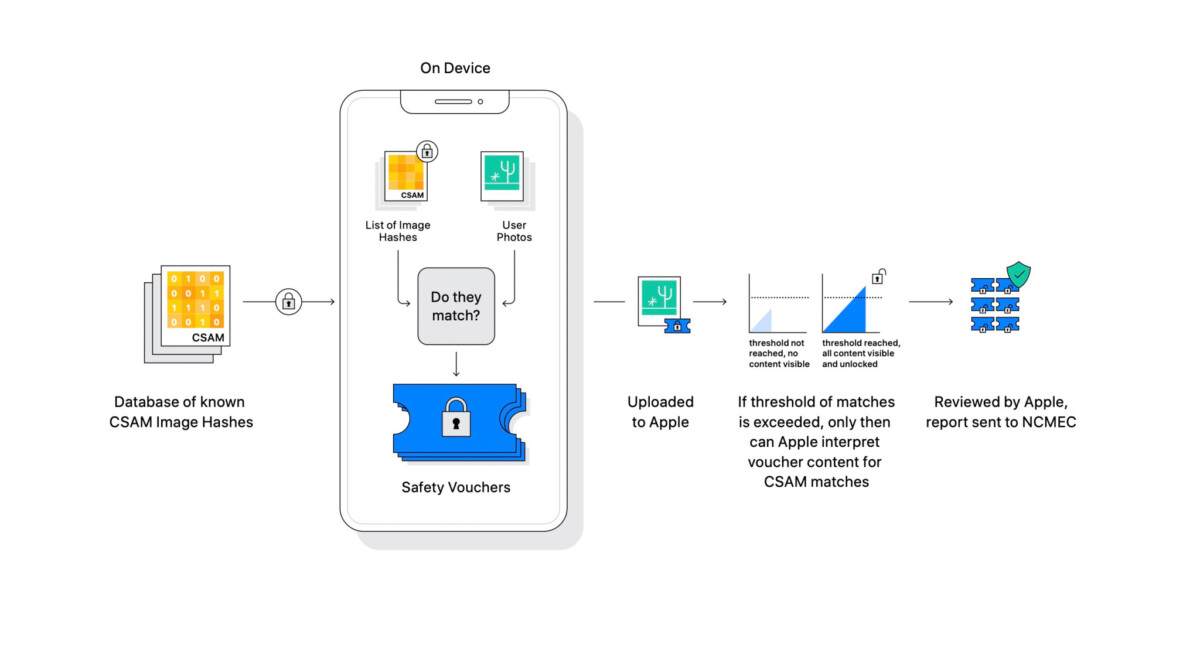

Certainement la fonction qui sera la plus médiatisée, Apple annonce de nouvelles mesures pour lutter contre la pédopornographie dont une fonction de détection automatique d’images à caractère pornographique. La détection se fera directement sur l’iPhone, si les images sont synchronisées ou sauvegardées sur iCloud. En cas d’une détection, Apple pourra déchiffrer ces images et les envoyer aux autorités sans prévenir l’utilisateur, avec des éléments d’identification nécessaire pour l’enquête. Cette fonction sera déployée dans iOS 15 et aux Etats-Unis pour le moment.

Comment fonctionne la détection automatique ?

Dans une série de documents, Apple rentre dans les détails de la solution technique utilisée. Apple analyse les images sur votre appareil pour voir s’il existe des correspondances avec une base de données de photographies connues fournies par le National Center for Missing and Exploited Children. Toute la correspondance est effectuée sur l’appareil, Apple transforme la base de données du National Center for Missing and Exploited Children en un « ensemble illisible de hachages qui est stocké en toute sécurité sur les appareils des utilisateurs ».

S’il y a une correspondance sur l’appareil, l’appareil crée alors une suite cryptographique qui enregistre le résultat de la correspondance. Une technologie appelée secret réparti est alors employée. Cela garantit que le contenu des suites cryptographiques ne peut pas être interprété par Apple à moins que le compte iCloud Photos ne dépasse un seuil de contenu illégal.

Apple ne divulgue pas le seuil spécifique qu’il utilisera, c’est-à-dire le nombre de correspondances requises avant de pouvoir interpréter le contenu des suites cryptographiques. Une fois ce seuil atteint, cependant, Apple examinera manuellement le rapport pour confirmer la correspondance, puis désactivera le compte de l’utilisateur et enverra un rapport au National Center for Missing and Exploited Children.

Même si tout analysé sur l’appareil, Apple utilise cette fonction uniquement sur les photos stockées dans iCloud Photos. Les images stockées entièrement localement ne sont pas impliquées dans ce processus. Selon Apple, ce système est respectueux de la confidentialité de ses utilisateurs.

Des voix s’élèvent déjà contre cette fonction, qui serait un précédent potentiellement dangereux pour la vie privée. Guillaume Champeau, responsable juridique chez Qwant, se demande si Apple saura-t-il résister aux inévitables demandes d’extension. Il faudra également vérifier si une telle fonction peut être juridiquement déployée en France et en Europe.

En tout cas, historiquement sur Internet ce qui a été fait pour lutter dans un premier temps contre ce type de contenus a souvent été étendu progressivement par la suite à d’autres catégories de contenus illicites. Apple saura-t-il résister aux inévitables demandes d’extension ?

— Guillaume Champeau (@gchampeau) August 5, 2021

Aucune réponse